与此同时,CLIP框架也存在多种技术局限性。10月25日,在由DataFun技术社区策划的DACon数智大会分论坛上,格灵深瞳技术副总裁、灵感实验室负责人冯子勇博士分享专题演讲:《多模态特征嵌入的数据生成和技术前沿》,介绍多模态基础模型的应用场景、技术短板,以及灵感团队的解题方法与技术细节——灵感图文多模态表征模型系列(Glint-ME)。

“大模型前沿技术探索”分论坛现场

数据生成:丰富又优质的多模态表征数据

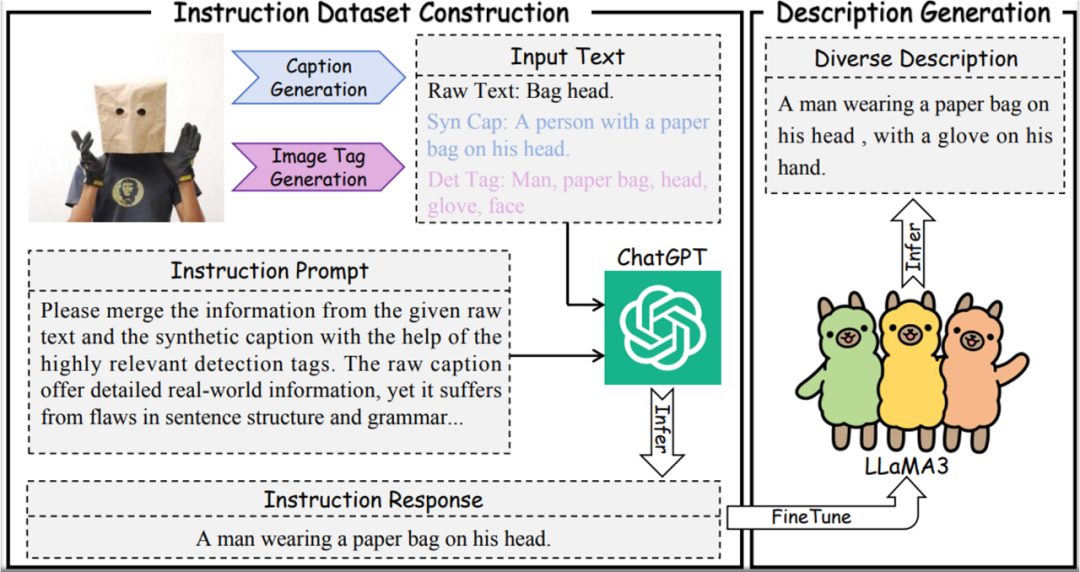

多模态模型训练需文本和图片成对出现,但现有数据文本质量不佳。为此,灵感团队提出了一个多样化描述生成框架,将Transformer的有效并行训练与RNN的有效推理相结合,利用大型语言模型来精炼原始文本、合成字幕和检测标签等信息,以产生语义丰富的描述文本。

描述生成框架示意图

为解决训练数据冗余的问题,灵感团队提出了一种简单但有效的图像语义平衡方法,能够在保持卓越性能的同时,从LAION 400M数据集中移除43.7%的图像-文本对。

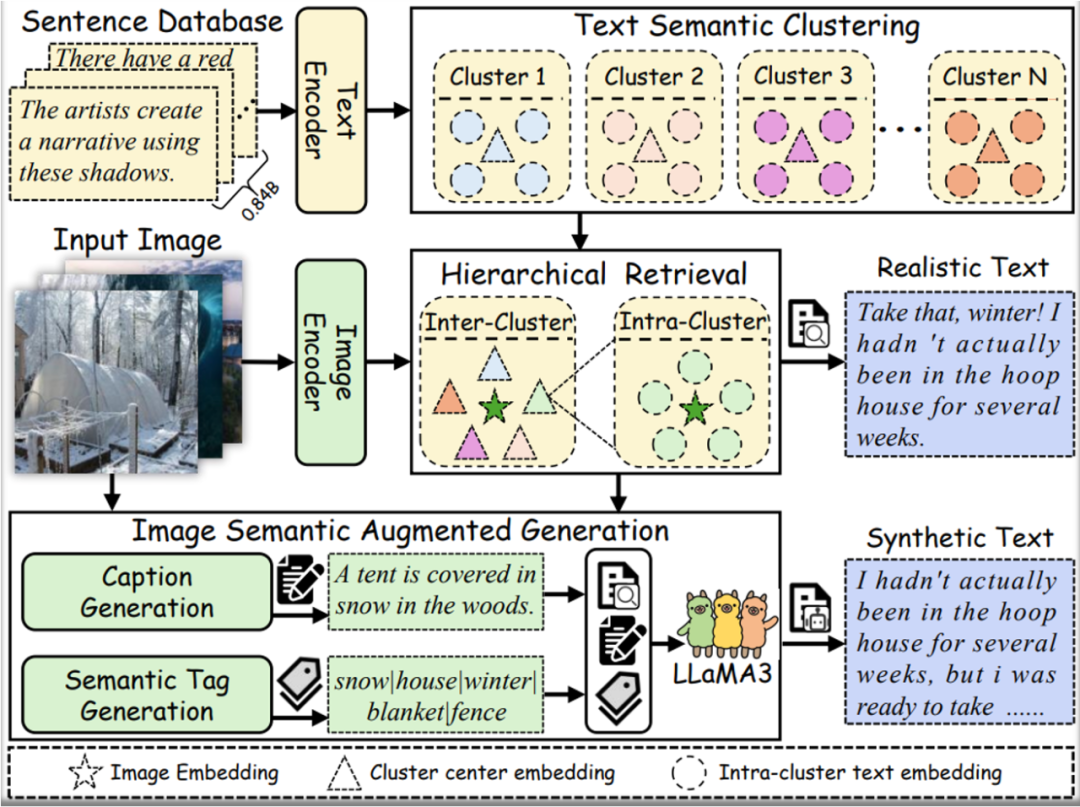

为挖掘现实中大量未配对的多模态数据,例如图文交织的文档,灵感团队提出了一种有效且可扩展的多模态交错文档转换范式,构建了RealSyn数据集,可以将此类数据用于CLIP预训练。

团队首先建立了一套真实数据提取流程,能够从图文交错的文档中提取高质量的图像和文本。在此基础上,构建了检索增强生成框架,基于高质量的文本和图片库,为每一张图片匹配现实文本和合成文本。

RealSyn数据生成流程示意图

RealSyn数据集包含15M、30M、100M三个规模。大量实验证明:RealSyn具有良好的数据缩放和模型缩放能力,相关数据、代码和模型均已开源:

技术报告:

https://arxiv.org/abs/2502.12513

代码:

https://github.com/deepglint/RealSyn

项目主页:

https://garygutc.github.io/RealSyn/

数据集:

https://huggingface.co/datasets/Kaichengalex/RealSyn100M

多模态特征嵌入模型:更强大的跨模态表达能力

尽管最近的多模态大型语言模型(MLLMs)在通用视觉-语言理解方面取得了显著进展,但在学习可迁移的多模态表征方面,潜力尚未充分发挥。

为此,灵感团队提出了一个面向MLLMs的两阶段训练框架UniME(Universal Multimodal Embedding,通用多模态嵌入),并优化迭代至V2版本——聚焦如何借助MLLMs强大的理解能力来助力统一多模态表征学习。

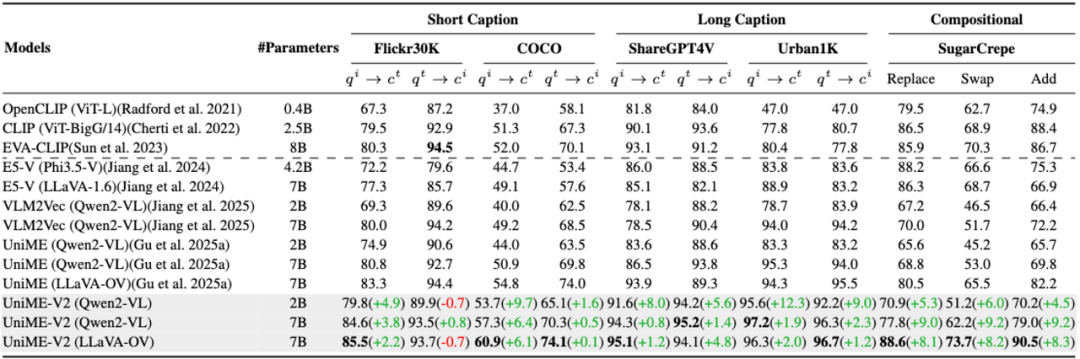

经过MMEB基准测试和在多个检索任务(包括长短文本跨模态检索和组合检索)上的大量实验,结果表明UniME-V2在多项任务中均实现了稳定的性能提升,展现了卓越的判别能力和组合理解能力。 UniME-V2在MMEB Benchmark的表现

UniME-V2在MMEB Benchmark的表现

UniME-V2在长短文本跨模态检索和组合检索上优于UniME-V1和其他模型

UniME系列论文、代码、权重均已开源:

UniME-V1

技术报告:

https://arxiv.org/abs/2504.17432

代码:

https://github.com/deepglint/UniME

模型:

https://huggingface.co/DeepGlint-AI/UniME-LLaVA-OneVision-7B

项目主页:

https://garygutc.github.io/UniME/

UniME-V2

技术报告:

https://arxiv.org/abs/2504.17432

代码:

https://github.com/GaryGuTC/UniME-v2

模型:

https://huggingface.co/collections/TianchengGu/unime-v2-68ef708ac48066353b4a0806

项目主页:

https://garygutc.github.io/UniME-v2/

近期,灵感实验室联合LMMs-Lab发布了全流程开源的多模态大模型LLaVA-OneVision-1.5,复现路径清晰,8B模型预训练只需4天、1.6万美元。

LLaVA-OneVision-1.5

技术报告:

https://arxiv.org/abs/2509.23661

代码:

https://github.com/EvolvingLMMs-Lab/LLaVA-OneVision-1.5

模型:

https://huggingface.co/lmms-lab/LLaVA-OneVision-1.5-8B-Instruct

Demo:

https://huggingface.co/spaces/lmms-lab/LLaVA-OneVision-1.5

数据集:

Pretrain Data:https://huggingface.co/datasets/lmms-lab/LLaVA-One-Vision-1.5-Mid-Training-85M

Instruct Data:https://huggingface.co/datasets/lmms-lab/LLaVA-OneVision-1.5-Insturct-Data

未来,灵感实验室将持续聚焦视觉及多模态特征表达与应用,推动多模态技术在多元化应用场景的落地与创新。欢迎关注团队的最新技术进展。