8月28-30日,2025百度云智大会在北京举办。在算力平台专题论坛上,格灵深瞳技术副总裁、算法研究院院长冯子勇分享了《视觉基座:通向世界模型之路——格灵深瞳Glint-MVT让AI看懂世界》主题演讲,从热点话题“世界模型”引入,介绍格灵深瞳自研视觉基础模型Glint-MVT的发展脉络和技术亮点,讲述视觉模型基座如何让AI理解复杂世界。

专题论坛现场

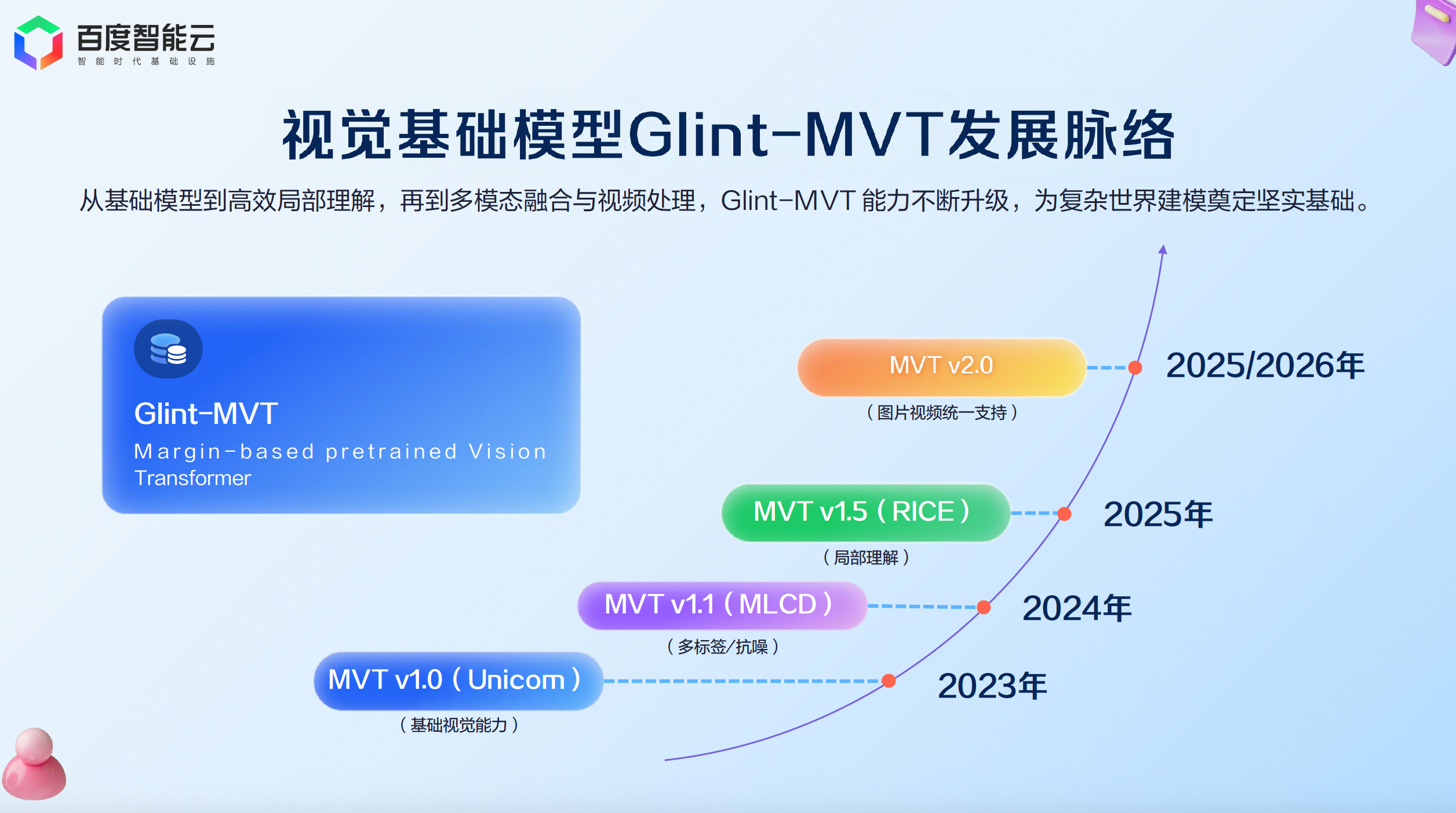

此次分享的主角:Glint-MVT(Margin-based pretrained Vision Transformer),是格灵深瞳灵感实验室自研的视觉基础模型。自2023年发布MVT v1.0以来,模型逐步迭代,在今年7月发布了MVT v1.5,同时MVT v2.0也在筹备中。

MVT的诞生:引入间隔Softmax函数

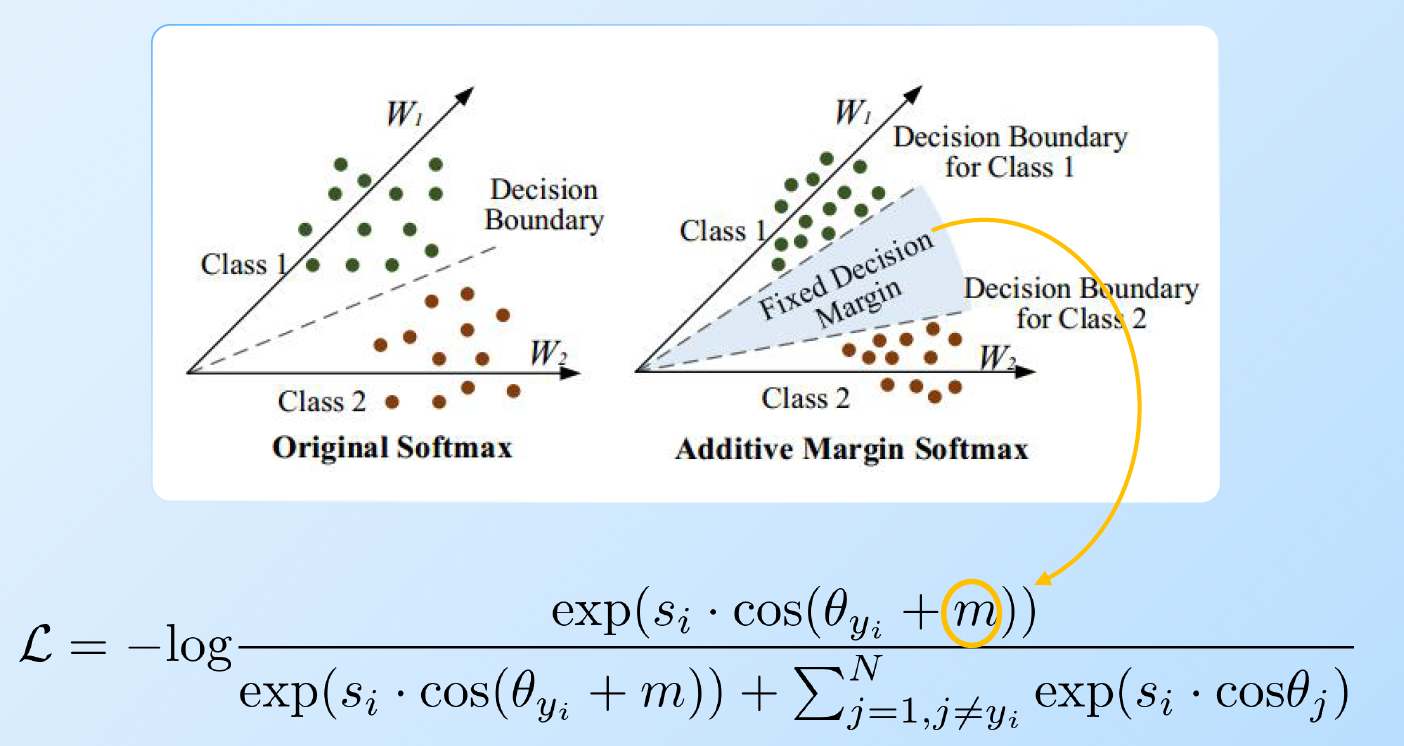

MVT最大的技术创新性在于,团队应用基于间隔的Softmax损失函数进行模型训练。Softmax损失函数主要应用于分类训练,而基于间隔的Softmax(Margin-based Softmax),可以让模型提取的特征更具区分度,提升视觉编码器的能力。

灵感团队将这一函数特性应用在视觉基础模型训练上,推出MVT v1.0,构建起视觉理解的坚实基础。

传统Softmax(左)与带间隔的Softmax(右)

在MVT v1.0训练过程中,团队通过特征聚类的方法,为4亿无标注图片打上伪标签,形成100万个类别。为解决伪标签类别太多和标签噪声的问题,团队提出了标签采样的方法,不仅大量减少卡间通信时延,还降低了标签噪声对训练精度的影响,带来训练效果和模型性能的双重提升。

从MVT v1.0到 v1.1:突破单标签限制

在图像识别过程中,一幅图像通常包含多个物体,对应着多个标签。因此,格灵深瞳将单标签升级为多标签,提升图像编码器的表达能力,由此得到MVT v1.1。

MVT v1.1可识别图像中的多个物体,这一能力提升源自损失函数的优化。灵感团队在1.0版softmax公式的基础上进行简单修改,让多个正标签参与计算;在工程上,由读取一个正类别的中心特征变成读取固定多个正类别的中心特征。

MVT v1.5:局部和文字特征再增强

随着下游任务对预训练模型能力的更高要求,灵感团队增强了模型对局部特征和文字特征的表达能力,推出MVT v1.5。

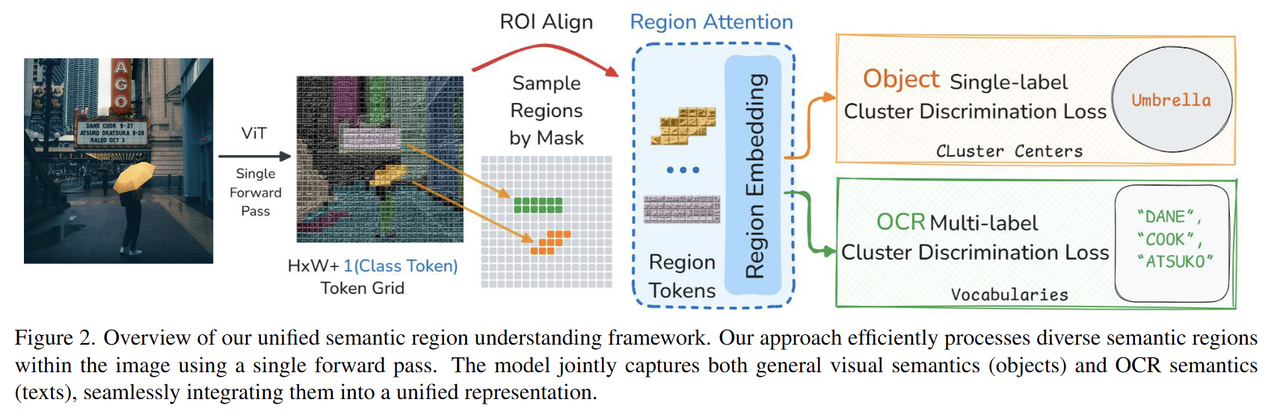

Region Attention技术方法示意图

在实现方法上,团队利用专家分割模型和OCR模型,生成局部数据伪标签,得到20亿局部区域和4亿文字区域。同时,团队提出了Region Attention的方法——利用Mask Attention机制,更高效地提取局部区域特征。从检测、分割等下游任务表现上看,MVT v1.5的多项分数高于SigLIP等模型。

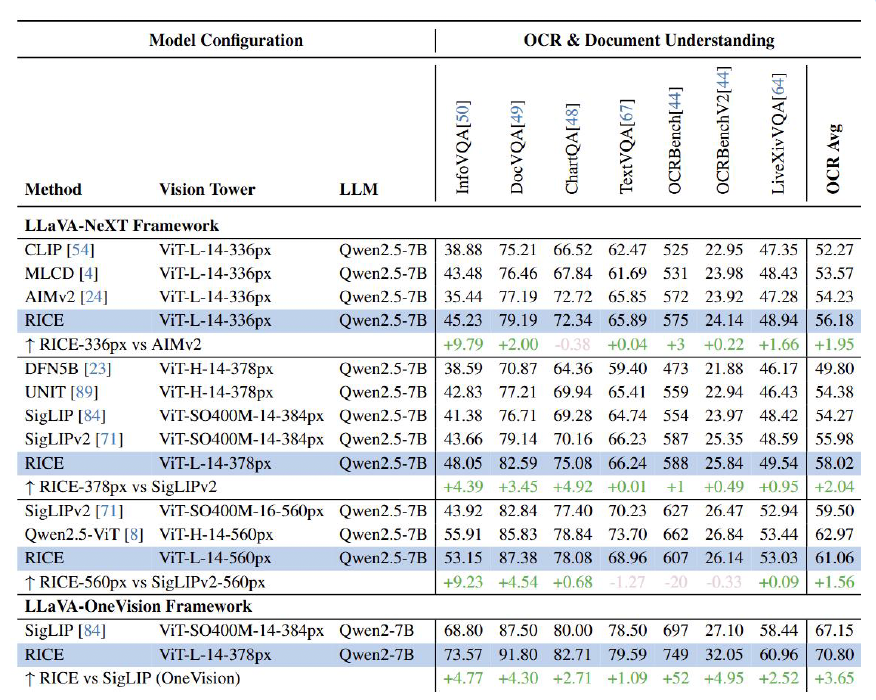

MVT v1.5(RICE)在OCR任务上的表现

灵感团队将MVT v1.5应用到VLM开源框架LLaVA-NeXT和LLaVA-OneVision中。对比其他视觉编码器,如OpenAI的CLIP、谷歌的SigLIP、苹果的DFN5B和AIMv2,MVT v1.5在OCR任务上表现更优。这表明MVT v1.5在局部和文字特征上具有更好的表达能力。

MVT v2.x:图片视频统一支持

人类和环境的交互以及任务完成,不只是一张张离散的图片,而是一个时空连续的视频流。下一步,灵感团队计划对视频进行高效编码,推出统一支持图片视频的视觉编码器MVT v2.x,提升视频特征表达能力。

📌 欢迎持续关注灵感实验室的最新技术进展