近日,国际顶级会议ICCV 2025(计算机视觉国际大会)公布论文录用结果,格灵深瞳团队共有6篇论文入选。

作为CV领域最具国际影响力的三大顶级会议之一,本届ICCV竞争十分激烈。据公开信息,今年大会共收到11239份有效投稿,数量为史上最多。经过评审后,仅接受2698篇论文,录用率为24%。

格灵深瞳此次入选的6篇论文,涉及视觉基座模型、人脸3D重建、文档几何校正、人体动作生成、鲁棒三维重建等多个视觉AI研究关键方向,展现了格灵深瞳深耕多年的核心技术积累和前沿创新实力,每一项成果都具有前瞻的科研价值和实际应用意义。

此次入选的6篇论文核心内容如下:

视觉基座模型

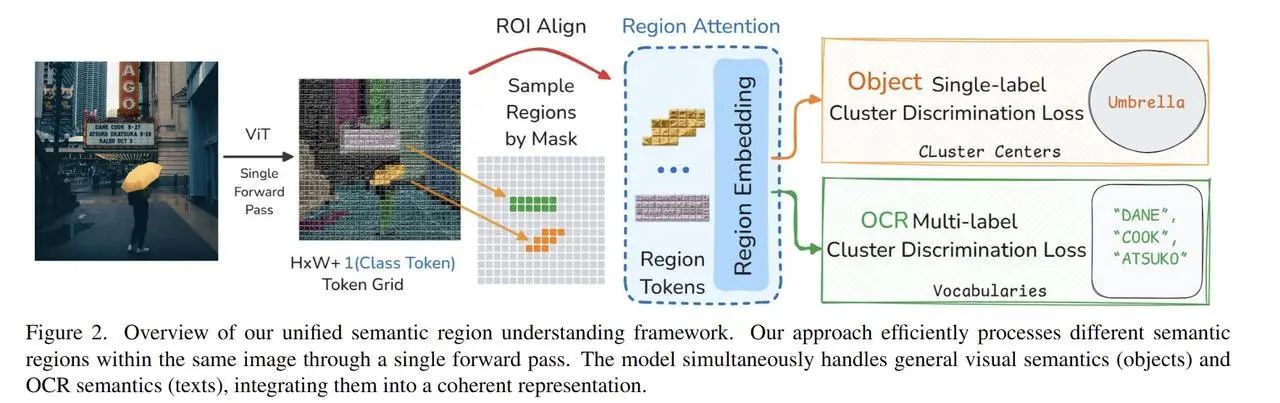

格灵深瞳与华为诺亚研究院合作的论文Region-based Cluster Discrimination for Visual Representation Learning中稿,其创新性在于,通过引入区域Transformer层和高效的区域聚类判别损失,有效提升视觉模型对局部区域信息的感知与表达能力,使其在OCR、目标检测和分割等密集视觉任务中表现突出。

同时,RICE采用大规模候选区域数据集,统一目标识别与OCR学习。在多项下游任务中,RICE均优于SigLIP2、AIMv2,无需显式语言监督,即可成为强大的多模态视觉大模型基座,展现出卓越的通用性和扩展潜力。

人脸3D重建、肤色估计

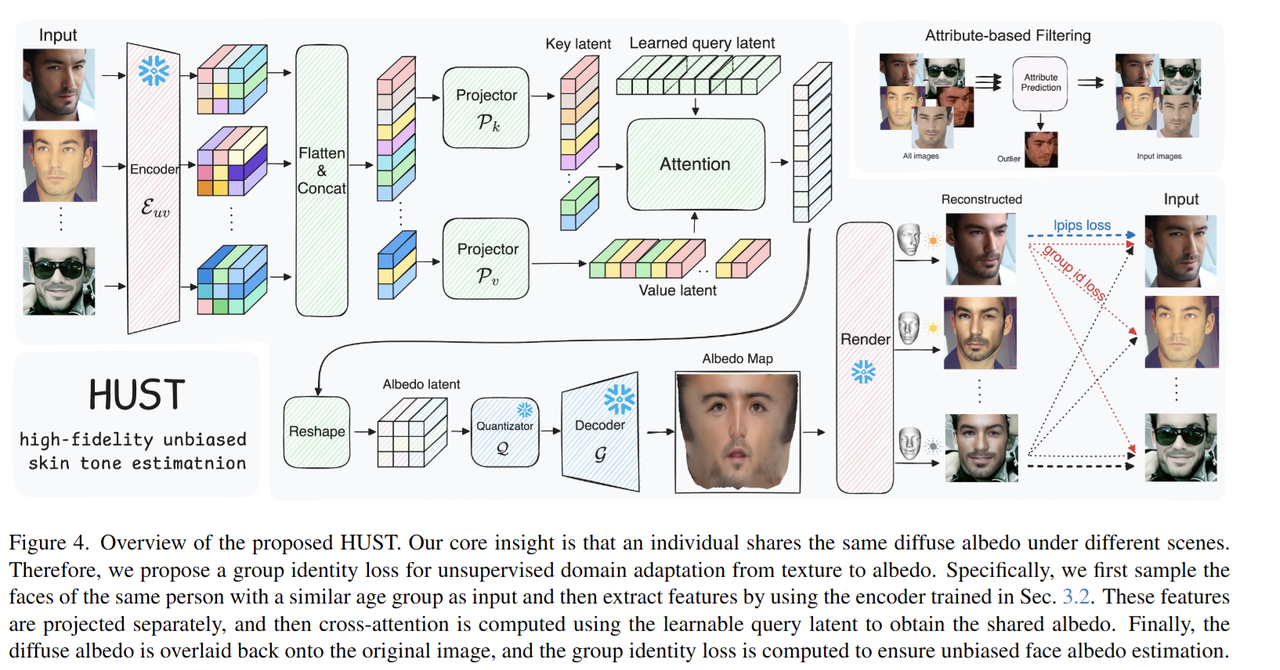

格灵深瞳与悉尼科技大学、浙江大学、帝国理工学院合作的HUST,方法创新性体现在:无需昂贵的光场采集数据,仅凭单张图片即可实现高保真、无偏见的人脸漫反射反照率重建。

该论文通过提出“反照率即去光照纹理”的新见解,结合VQGAN预训练和有限UV纹理微调,模型有效利用大规模高分辨率人脸数据。跨空间自适应与群体身份损失实现域迁移,提升了不同肤色的泛化能力。HUST在FAIR基准上取得了当前最优的准确性和公平性指标。

文档几何校正

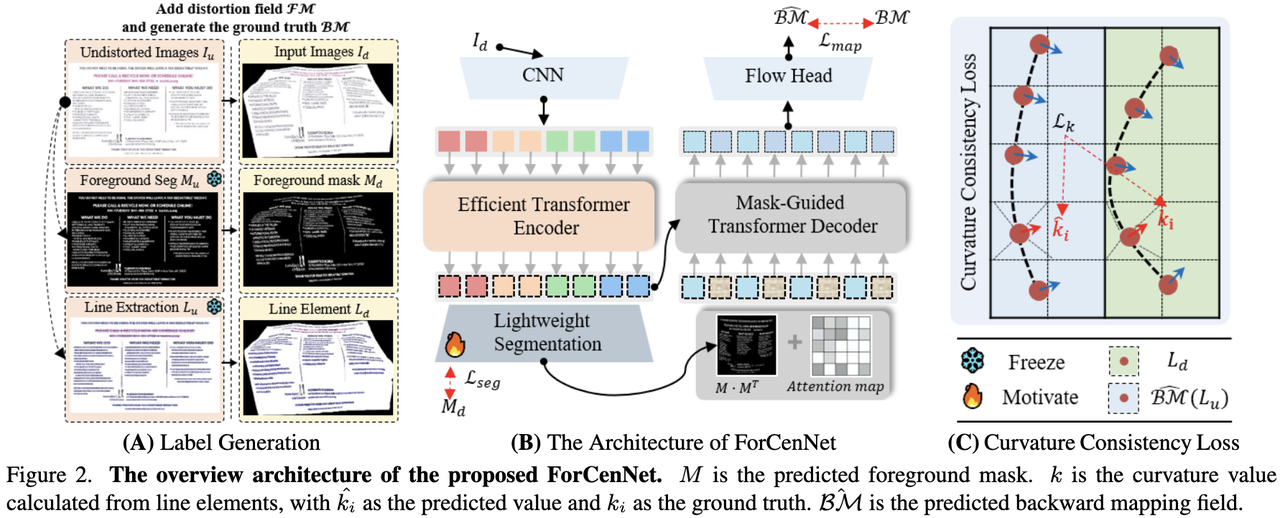

格灵深瞳与360移动算法部合作的ForCenNet,其创新性体现在:提出了前景为中心的标签生成方法和掩码机制,显著提升了对文档可读区域的几何校正能力。

同时,该论文方法设计了曲率一致性损失,有效约束线性结构的变形,提升了校正精度。实验结果表明方法在多个真实基准上均取得了新的最优表现。

人体动作生成

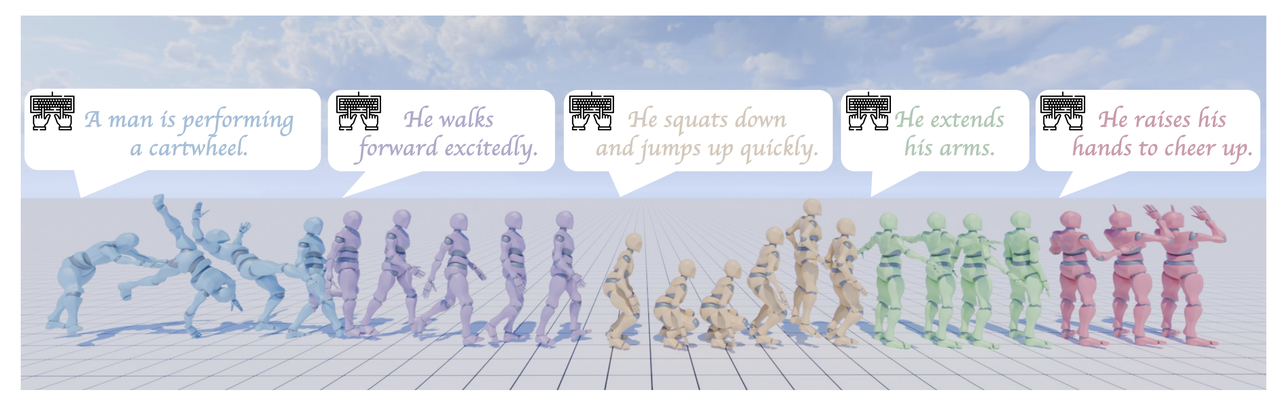

格灵深瞳与浙江大学合作的MotionStreamer,提出了一种全新的流式人体动作生成框架。通过在连续的因果潜空间中进行自回归,并使用扩散模型建模每个潜在变量的概率分布,实现高效的流式生成。

流式框架天然支持多轮交互式动作生成、长序列动作生成、动态动作组合等多种应用。

人体动作生成

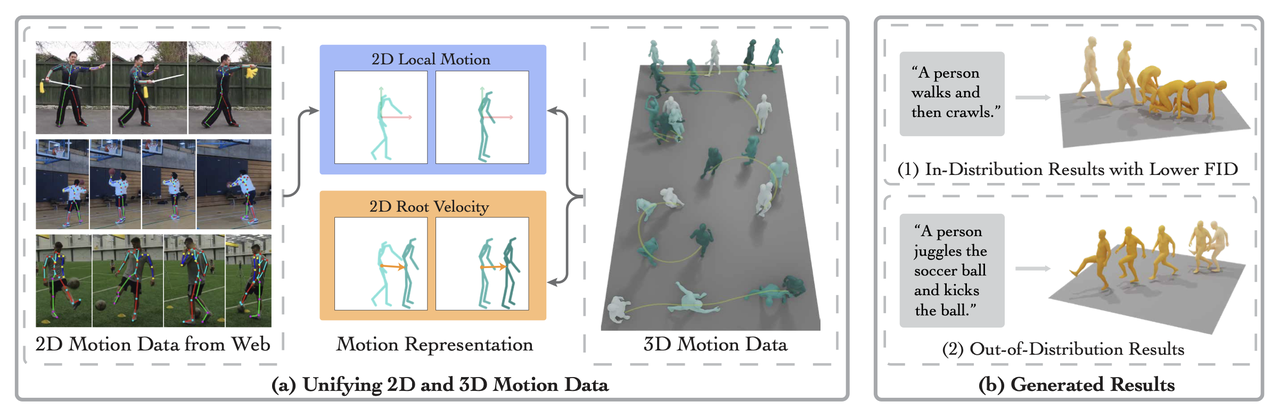

格灵深瞳与浙江大学合作的Motion-2-to-3,创新性地使用大量的人类二维视频,以提升文本驱动的三维运动生成。研究通过解耦局部关节运动与全局运动,从二维数据高效学习局部运动先验。先在大规模文本-二维运动数据集上训练单视角生成器,再用三维数据微调为多视角生成器,预测视角一致的局部关节运动和根节点动态。

实验表明,该方法能高效利用二维数据,生成更广泛,更多类型的真实三维人体运动,为相关行业带来新机遇。

鲁棒三维重建

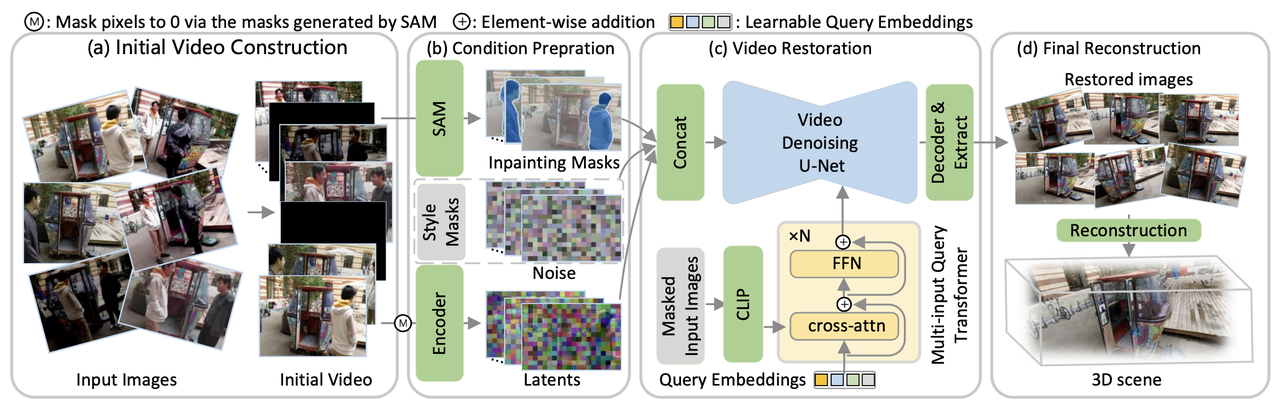

格灵深瞳与浙江大学合作的UniVerse,首次将视频扩散模型引入到鲁棒3D重建中,通过先把不一致的多视图图像转化为一致视频帧,再进行高质量神经场重建,有效解耦了“修复”和“重建”两大任务。

近年来,格灵深瞳大力投入视觉基础模型、多模态大模型等AI核心技术研发,积极与各大高校、企业开展研究合作,聚合产学研力量,促进学术深度交流。此次亮相国际顶级学术平台,是对团队科研实力与成果的检验和肯定。

未来,格灵深瞳将持续发力前沿技术创新研究,促进科研成果转化应用,引领行业共同发展进步。